2019. 12. 19. 20:49ㆍPapers/Object Detection

Real-Time Object Detection

- 현재 프레임(이미지)에서의 물체(객체)의 Localization(위치)와 class(클래스)를 도출하는 것

- 이를 실시간으로 객체를 검출하는 것이 목표

- 정확도 & 속도 2가지의 속성의 trade off가 존재. 따라서 이 두가지의 성능을 동시에 높이는 것이 목표

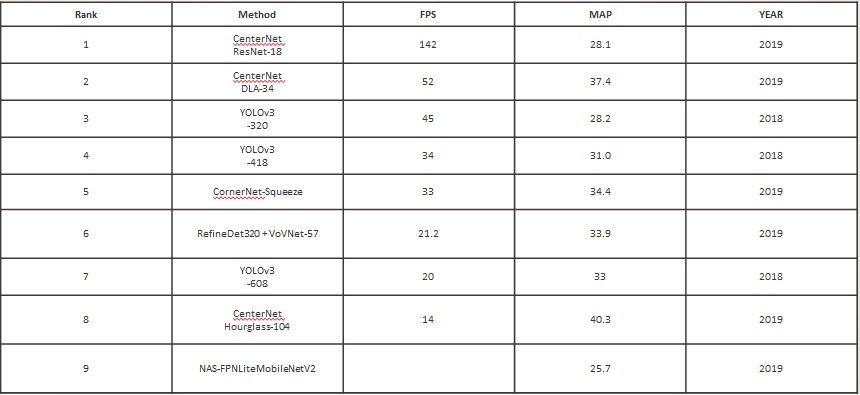

COCO dataset기준 Real-Time Object Detection 순위

YOLO

-

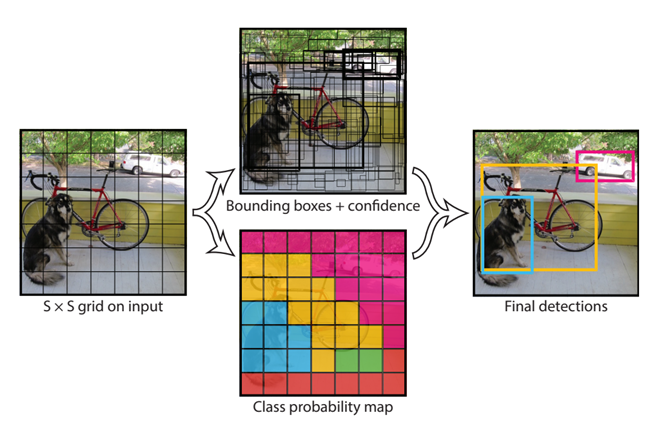

One-stage detector의 종류 중 하나

- Classification과 boudning box regression을 한번에 수행

- Classification과 bounding box regression을 따로 수행하는 Two-stage detector보다 정확도는 낮으나, 처리속도와 효율성이 높기 때문에 현재 많이 사용하는 경향

-

YOLO

- Darknet이라는 backbone 모델을 사용

- a모델을 복잡하게 만드는 것이 아니라 보다 간편하게 만들어서 속도가 빠름

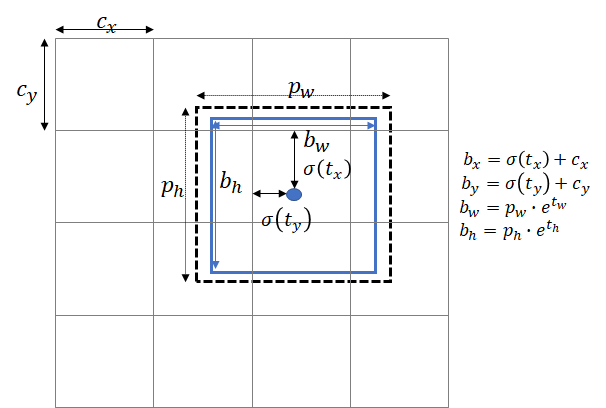

- Anchor box를 통해 bounding box를 예측함

- 모든 Object-Detection에서 나타나는 작은 물체에 대한 검출률은 여전히 낮음

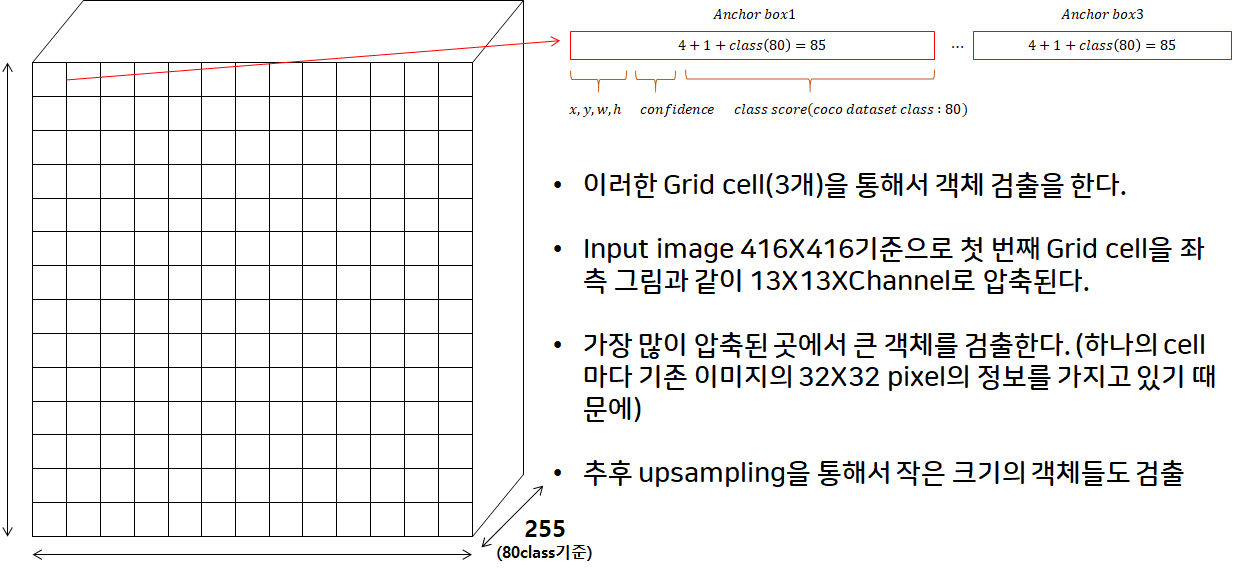

Grid cell

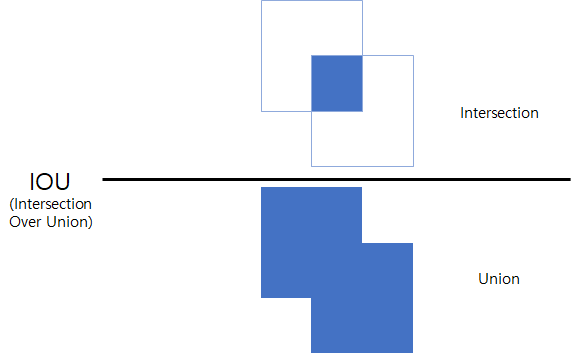

IoU ( Intersection Over Union )

-

IoU

-

객체 검출을 할 때 예측한 객체에 대한 정보를 가지는 Bounding box와 정답 Box의 IoU를 통해서 임계 값(threshold)이 0.5 이상일 경우 일치하는 객체로 판단하는 작업을 한다.

-

임계 값이 높을수록 정답과 일치함을 의미하는데 기준 임계 값을 너무 높게 한다면 검출율이 낮아지기 때문에 적당한 임계 값을 설정하는 것이 중요하다. ( 대표적인 값이 0.5 )

-

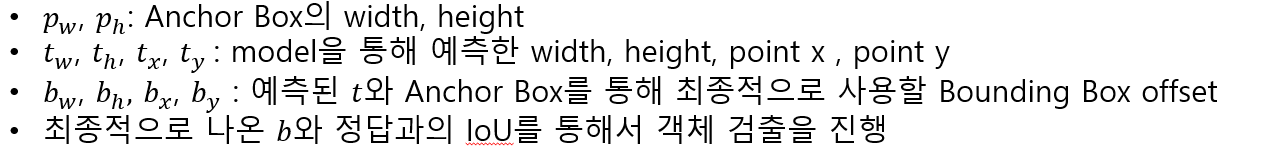

Bounding Box

NMS ( non-maximum-suppression )

- 다양한 크기의 객체들을 검출했을 경우 같은 객체에 여러 개의 Bounding box가 생기는 현상을 볼 수 있다. 이를 방지하기 위해서 가장 정답 객체와 유사한 객체를 제외한 나머지 Bounding box들을 제거해주는 작업이 필요한데 이를 NMS를 통해서 처리한다.

Reference

-

You Only Look Once: Unified, Real-Time Object Detection. Joseph Redmon et al.; The IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2016, pp. 779-788

-

YOLO9000: Better, Faster, Stronger. Josep Redmon, Ali Farhadi; The IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2017, pp. 7263-7271

-

YOLO9000: Better, Faster, Stronger. Josep Redmon, Ali Farhadi; Computer Vision and Pattern Recognition (cs.CV), 2018, arXiv:1804.02767[cs.CV]